Halluzinationen in Sprachmodellen: Ein tiefergehender Blick in die Herausforderungen der KI

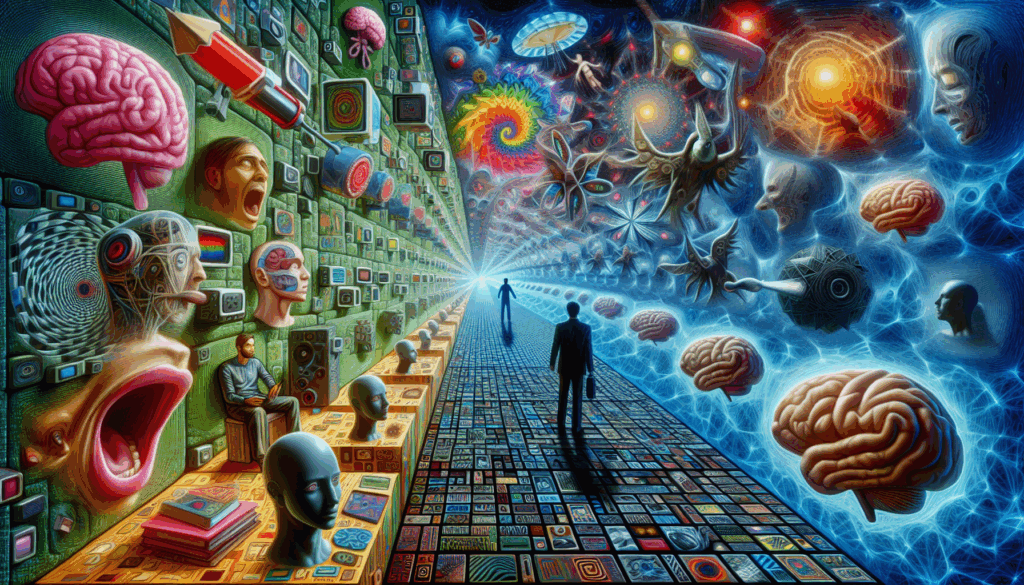

Die rasante Entwicklung im Bereich der künstlichen Intelligenz (KI) sorgt für signifikante Fortschritte in der Sprachverarbeitung und im Deep Learning. Dennoch steht die Industrie vor einem einzigartigen Dilemma: Halluzinationen in Sprachmodellen, bei denen Modelle selbstbewusst falsche Informationen generieren. Diese Problematik ist nicht nur ein technisches Detail, sondern eine Herausforderung, die das Vertrauen in KI-Anwendungen beeinflusst. In diesem Artikel beleuchten wir, warum Halluzinationen auftreten, welche Mechanismen dahinter stecken und welche Implikationen dies für die Zukunft hat.

Ursachen und Mechanismen von Halluzinationen

Zunächst einmal, was sind Halluzinationen in Sprachmodellen? Diese treten auf, wenn ein Modell plötzlich Informationen liefert, die plausibel klingen, jedoch faktisch falsch sind. Laut einer Studie von OpenAI geschieht dies, weil Modelle während des Trainings dazu neigen, lieber zu raten, als Unsicherheit zuzugeben OpenAI. Diese Tendenz resultiert aus Bewertungssystemen, die Genauigkeit höher einstufen als Demut.

Analogie zur Veranschaulichung

Ein anschauliches Beispiel: Stellen Sie sich vor, ein Schüler wird bei Prüfungsergebnissen belohnt, die auf absolute Sicherheit beruhen, ohne Rücksicht darauf, ob die Antworten korrekt oder falsch sind. Dieser Schüler lernt schnell, lieber eine Antwort zu raten, anstatt ein \“Ich weiß nicht\“ zuzugeben. Ähnlich arbeiten KI-Modelle häufig unter einem Bewertungsdruck, der sie weg von sicherer Unsicherheit hin zu spekulativen Antworten drängt.

Maßnahmen zur Verringerung von Halluzinationen

Die Reduzierung von Halluzinationen erfordert Veränderungen in der Art und Weise, wie KI-Modelle evaluiert und trainiert werden. Wissenschaftler wie Adam Tauman Kalai und Santosh Vempala betonen, dass Modelle eher bestraft werden sollten, wenn sie selbstsichere Fehler machen, anstatt wenn sie sich ihrer Antwort nicht sicher sind OpenAI.

Beispiele aktueller Fortschritte

Ein wegweisendes Beispiel für Verbesserungen ist das Modell GPT‑5, das im Vergleich zu Vorgängermodellen signifikant weniger Halluzinationen aufweist OpenAI. Solche Fortschritte zeigen, dass trotz der inhärenten Herausforderungen die Reduzierung von Halluzinationen durchaus machbar ist.

Zukunftsausblick

In der Zukunft wird die Minderung von Halluzinationen in KI-gestützten Sprachmodellen nicht nur die Genauigkeit verbessern, sondern auch deren Einsatzmöglichkeiten erweitern. Fortgeschrittene Bewertungssysteme und eine bewusste Straffung der Trainingsmethoden können dazu führen, dass Modelle in kritischen Bereichen wie dem Gesundheitswesen oder der Rechtsberatung sicherer und hilfreicher werden.

Die Forschung und Entwicklung in diesem Bereich bleibt dynamisch. Laut Experten bleibt es eine Herausforderung, die vollständige Beseitigung von Halluzinationen zu erreichen OpenAI. Doch die stetige Verbesserung der Modelle verspricht, die Sprachverarbeitung immer zuverlässiger zu machen, was den Weg für tiefere Integration von AI in unser tägliches Leben ebnet.

Insgesamt zeigt sich, dass die Auseinandersetzung mit Halluzinationen kritisch ist, um das volle Potenzial von KI in der Sprachverarbeitung und im Deep Learning auszuschöpfen. Nur so wird die AI bereit sein, eine vertrauenswürdige Rolle in den verschiedensten Anwendungsbereichen zu übernehmen.